جوجل

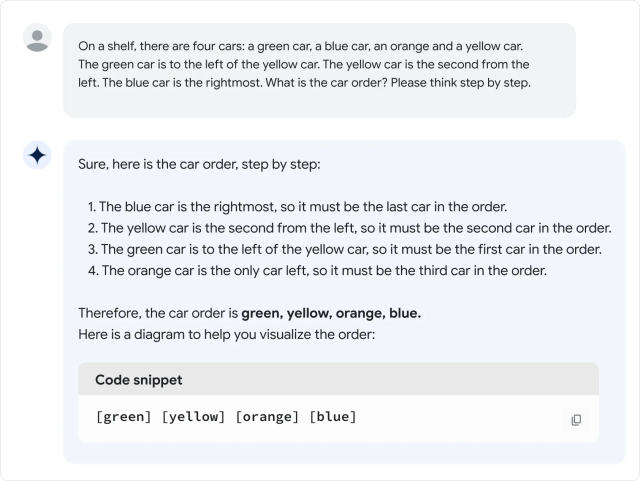

قدمت Google يوم الأربعاء PaLM 2 ، وهي مجموعة من نماذج اللغات الأساسية التي يمكن مقارنتها بنماذج OpenAI’s GPT-4. في حدث Google I / O في ماونتن فيو ، كشفت Google أنها تستخدم بالفعل PaLM 2 لتشغيل 25 منتجًا مختلفًا ، بما في ذلك مساعد AI للمحادثة الرائع.

كعائلة من نماذج اللغات الكبيرة (LLMs) ، تم تدريب PaLM 2 على حجم هائل من البيانات ويقوم بالتنبؤ بالكلمة التالية ، والذي ينتج النص الأكثر احتمالية بعد إدخال سريع من قبل البشر. يرمز PaLM إلى “Pathways Language Model” ، وبدوره ، “Pathways” هو أسلوب للتعلم الآلي تم إنشاؤه في Google. متابعة PaLM 2 على PaLM الأصلي ، الذي أعلنته Google في أبريل 2022.

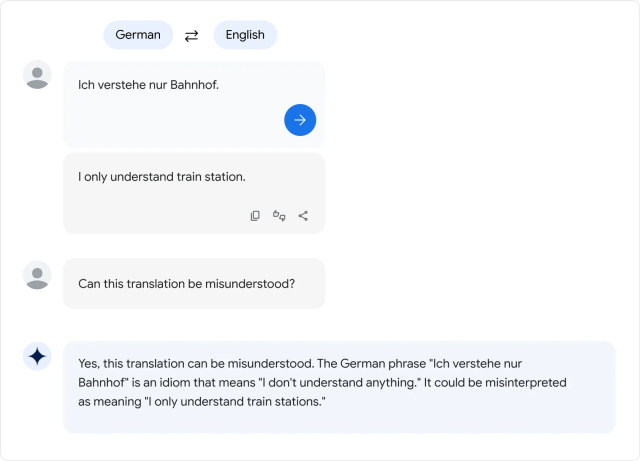

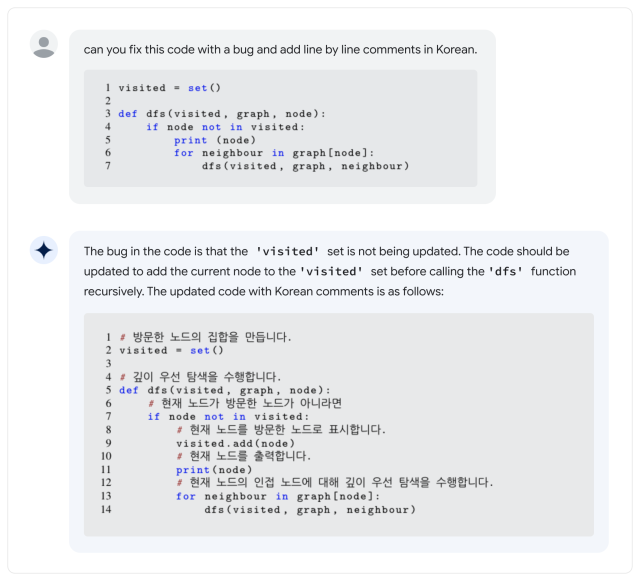

وفقًا لـ Google ، يدعم PaLM 2 أكثر من 100 لغة ويمكنه إجراء “التفكير المنطقي” وإنشاء الكود والترجمة متعددة اللغات. خلال كلمته الرئيسية في مؤتمر Google I / O لعام 2023 ، قال سوندار بيتشاي ، الرئيس التنفيذي لشركة Google ، إن PaLM 2 يأتي بأربعة أحجام: Gecko و Otter و Bison و Unicorn. أبو بريص هو الأصغر ويمكن تشغيله على جهاز محمول. بصرف النظر عن Cool ، فإن PaLM 2 وراء ميزات AI في المستندات وجداول البيانات والعروض التقديمية.

جوجل

كل هذا جيد وجيد ، ولكن كيف يتكدس PaLM 2 حتى GPT-4؟ في التقرير الفني PaLM 2 ، PaLM 2 يبدو للتغلب على GPT-4 في بعض المهام الرياضية والترجمة والاستدلال. لكن الواقع قد لا يتطابق مع معايير Google. في تقييم سريع لإصدار PaLM 2 من Bard بواسطة Ethan Mollick ، أستاذ وارتون والذي غالبًا ما يكتب عن الذكاء الاصطناعي ، وجد Mollick أن أداء PaLM 2 يبدو أسوأ من GPT-4 و Bing في مجموعة متنوعة من اختبارات اللغة غير الرسمية ، وهو مفصلة في موضوع Twitter.

حتى وقت قريب ، كانت عائلة نماذج اللغات PaLM منتجًا داخليًا لأبحاث Google بدون تعرض للمستهلكين ، لكن Google بدأت في تقديم وصول محدود إلى واجهة برمجة التطبيقات في مارس. ومع ذلك ، كان أول PaLM ملحوظًا بحجمه الضخم: 540 مليار معلمة. المعلمات هي متغيرات عددية تعمل بمثابة “معرفة” بالنموذج ، مما يمكنها من عمل تنبؤات وإنشاء نص بناءً على المدخلات التي يتلقاها.

جوجل

يعني المزيد من المعلمات تقريبًا مزيدًا من التعقيد ، ولكن ليس هناك ما يضمن استخدامها بطريقة فعالة. بالمقارنة ، تحتوي GPT-3 الخاصة بـ OpenAI (بدءًا من 2020) على 175 مليار معلمة. لم تكشف OpenAI مطلقًا عن عدد المعلمات في GPT-4.

وهذا يؤدي إلى السؤال الكبير: ما مدى “حجم” PaLM 2 من حيث عدد المعلمات؟ جوجل لا يقولوقد أحبط هذا البعض خبراء الصناعة الذين غالبًا ما يناضلون من أجل المزيد من الشفافية فيما يجعل نماذج الذكاء الاصطناعي علامة.

هذه ليست الخاصية الوحيدة لـ PaLM 2 التي لم تتجاهلها Google. تقول الشركة أن PaLM 2 قد تم تدريبه على “مجموعة متنوعة من المصادر: مستندات الويب ، والكتب ، والرموز ، والرياضيات ، وبيانات المحادثة” ، ولكنها لا تخوض في التفاصيل حول ماهية تلك البيانات بالضبط.

كما هو الحال مع مجموعات بيانات نموذج اللغة الكبيرة الأخرى ، من المحتمل أن تتضمن مجموعة بيانات PaLM 2 مجموعة متنوعة من مواد محفوظة الحقوق تُستخدم بدون إذن وأيضًا مواد قد تكون ضارة تم إزالتها من الإنترنت. تؤثر بيانات التدريب بشكل حاسم على مخرجات أي نموذج للذكاء الاصطناعي ، لذلك دعا بعض الخبراء إلى استخدام مجموعات البيانات المفتوحة التي يمكن أن توفر فرصًا للتكاثر العلمي والتدقيق الأخلاقي.

جوجل

“الآن بعد أن أصبحت LLM منتجات (وليست مجرد بحث) ، فإننا عند نقطة تحول: ستصبح الشركات الهادفة للربح أقل شفافية * على وجه التحديد * حول المكونات الأكثر أهمية ،” غرد جيسي دودج ، عالم أبحاث في معهد ألين للذكاء الاصطناعي. “فقط إذا تمكن مجتمع المصادر المفتوحة من التنظيم معًا ، يمكننا مواكبة ذلك!”

حتى الآن ، لم يمنع انتقاد إخفاء الصلصة السرية Google من متابعة نشر نماذج الذكاء الاصطناعي على نطاق واسع ، على الرغم من الميل في جميع LLMs إلى اختلاق الأشياء من فراغ. خلال مؤتمر Google I / O ، قام ممثلو الشركة بتجريب ميزات الذكاء الاصطناعي في العديد من منتجاتها الرئيسية ، مما يعني أن قطاعًا واسعًا من الجمهور يمكن أن يحارب مشكلات الذكاء الاصطناعي قريبًا.

وفيما يتعلق بـ LLMs ، فإن PaLM 2 بعيدة كل البعد عن نهاية القصة: في الكلمة الرئيسية I / O ، ذكر بيتشاي أن نموذجًا جديدًا للذكاء الاصطناعي متعدد الوسائط يسمى “الجوزاء” كان قيد التدريب حاليًا. مع استمرار السباق على هيمنة الذكاء الاصطناعي ، يمكن لمستخدمي Google في الولايات المتحدة و 180 دولة أخرى (باستثناء كندا والبر الرئيسي لأوروبا) تجربة PaLM 2 بأنفسهم كجزء من Google Bard ، مساعد الذكاء الاصطناعي التجريبي.