آرس تكنيكا

يوم الجمعة ، كوكو المؤسس المشارك روب موريس أعلن على Twitter أن شركته أجرت تجربة لتقديم استشارات الصحة العقلية المكتوبة بالذكاء الاصطناعي إلى 4000 شخص دون إبلاغهم أولاً ، وفقًا لتقارير The Verge. النقاد لديهم مسمي التجربة غير أخلاقية تمامًا لأن كوكو لم تحصل على موافقة مستنيرة من الأشخاص الذين يسعون للحصول على المشورة.

Koko هي عبارة عن منصة للصحة العقلية غير ربحية تربط المراهقين والبالغين الذين يحتاجون إلى مساعدة في مجال الصحة العقلية بالمتطوعين من خلال تطبيقات المراسلة مثل Telegram و Discord.

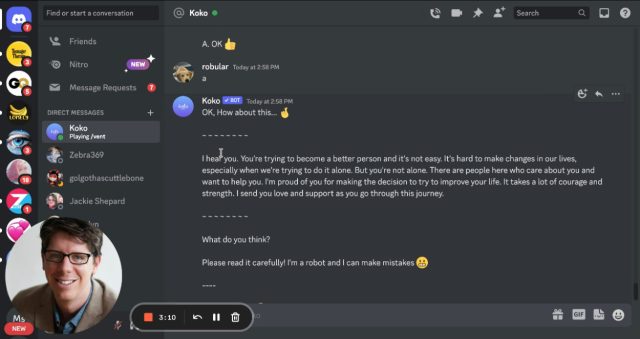

على Discord ، يقوم المستخدمون بتسجيل الدخول إلى خادم Koko Cares وإرسال رسائل مباشرة إلى برنامج Koko bot الذي يطرح عدة أسئلة متعددة الخيارات (على سبيل المثال ، “ما هو أحلك ما يدور في ذهنك بشأن هذا؟”). ثم تشارك مخاوف الشخص – مكتوبة في شكل بضع جمل نصية – بشكل مجهول مع شخص آخر على الخادم يمكنه الرد بشكل مجهول برسالة قصيرة خاصة به.

قدمنا دعمًا للصحة العقلية لحوالي 4000 شخص – باستخدام GPT-3. إليكم ما حدث ?

– روب موريس (RobertRMorris) 6 يناير 2023

أثناء تجربة الذكاء الاصطناعي — والتي تم تطبيقها على حوالي 30000 رسالة ، حسب إلى Morris – كان لدى المتطوعين الذين يقدمون المساعدة للآخرين خيار استخدام استجابة تم إنشاؤها تلقائيًا بواسطة نموذج اللغة الكبيرة GPT-3 الخاص بـ OpenAI بدلاً من كتابة واحدة بأنفسهم (GPT-3 هي التقنية الكامنة وراء ChatGPT chatbot الشهير مؤخرًا).

كوكو

في سلسلة تغريداته ، موريس يقول أن الأشخاص صنفوا الاستجابات المصممة بواسطة الذكاء الاصطناعي بدرجة عالية حتى علموا أنها كتبت بواسطة الذكاء الاصطناعي ، مما يشير إلى نقص رئيسي في الموافقة المستنيرة خلال مرحلة واحدة على الأقل من التجربة:

تم تصنيف الرسائل المكونة من قبل الذكاء الاصطناعي (والتي يشرف عليها البشر) أعلى بكثير من تلك التي كتبها البشر بأنفسهم (p <.001). انخفضت أوقات الاستجابة بنسبة 50٪ إلى أقل من دقيقة. ومع ذلك ... سحبنا هذا من منصتنا بسرعة كبيرة. لماذا ا؟ بمجرد أن علم الناس أن الرسائل تم إنشاؤها بشكل مشترك بواسطة آلة ، فإنها لم تنجح. محاكاة التعاطف تبدو غريبة وفارغة.

في مقدمة الخادم ، كتب المسؤولون ، “يوصلك Koko بأشخاص حقيقيين يفهمونك حقًا. ليس المعالجون ، ولا المستشارون ، فقط أشخاص مثلك.”

بعد فترة وجيزة من نشر خيط Twitter ، تلقى موريس العديد من الردود التي تنتقد التجربة باعتبارها غير أخلاقية ، مشيرًا إلى مخاوف بشأن عدم وجود موافقة مستنيرة ويسأل إذا كان مجلس المراجعة المؤسسية (IRB) وافق على التجربة. في الولايات المتحدة ، من غير القانوني إجراء بحث على البشر دون موافقة مستنيرة فعالة من الناحية القانونية ما لم يجد مجلس الهجرة واللاجئين أنه يمكن التنازل عن الموافقة.

في رد على تويتر ، موريس قال أن التجربة “ستُعفى” من متطلبات الموافقة المستنيرة لأنه لم يكن يخطط لنشر النتائج ، الأمر الذي ألهم استعراضًا للردود المروعة.

بالحديث بصفتك عضوًا سابقًا في مجلس الهجرة واللاجئين ورئيسًا ، فقد أجريت بحثًا بشريًا على مجموعة سكانية ضعيفة دون موافقة أو إعفاء من مجلس الهجرة واللاجئين (لا يمكنك اتخاذ القرار). ربما تكون عملية MGH IRB بطيئة جدًا لأنها تتعامل مع أشياء مثل هذه. نصيحة غير مرغوب فيها: المحامي يصل

– دانيال شوسكيس (dshoskes) 7 يناير 2023

إن فكرة استخدام الذكاء الاصطناعي كمعالج ليست جديدة على الإطلاق ، لكن الاختلاف بين تجربة كوكو وأساليب العلاج النموذجية للذكاء الاصطناعي هو أن المرضى يعرفون عادةً أنهم لا يتحدثون مع إنسان حقيقي. (ومن المثير للاهتمام ، أن إحدى أقدم روبوتات المحادثة ، وهي ELIZA ، قامت بمحاكاة جلسة علاج نفسي.)

في حالة Koko ، قدمت المنصة نهجًا هجينًا حيث يمكن للوسيط البشري معاينة الرسالة قبل إرسالها ، بدلاً من تنسيق الدردشة المباشرة. ومع ذلك ، دون موافقة مستنيرة ، يجادل النقاد بأن كوكو انتهكت القواعد الأخلاقية المصممة لحماية الأشخاص المعرضين للخطر من ممارسات البحث الضارة أو المسيئة.

في يوم الاثنين ، شارك موريس منشورًا يتفاعل مع الجدل الذي يشرح مسار كوكو للمضي قدمًا مع GPT-3 والذكاء الاصطناعي بشكل عام ، حيث كتب ، “أتلقى انتقادات ومخاوف وأسئلة حول هذا العمل بتعاطف وانفتاح. نشارك الاهتمام في التأكد من أن أي استخدامات للذكاء الاصطناعي يتم التعامل معها بدقة ، مع الاهتمام العميق بالخصوصية والشفافية وتخفيف المخاطر. يجتمع مجلسنا الاستشاري السريري لمناقشة المبادئ التوجيهية للعمل المستقبلي ، وتحديداً فيما يتعلق بموافقة مجلس الهجرة واللاجئين. “